LM Studio per eseguire LLM in Linux semplicemente

Liberati dai modelli AI limitati basati su cloud che sono troppo costosi e non rispettano la tua privacy installando Large Language Models (LLM) direttamente sul tuo computer con LM Studio e avrai anche un maggiore controllo sui tuoi dati, il tutto senza fare affidamento sulle grandi aziende tecnologiche.

LM Studio è un’applicazione desktop multi-piattaforma che facilita la scoperta, il download e l’esecuzione di LLM in locale su sistemi Linux, Windows e MacOS. È progettata per fornire un’interfaccia utente grafica semplice e potente, consentendo agli utenti di sperimentare con modelli di intelligenza artificiale open-source.

Ecco in sintesi alcune caratteristiche tecniche di LM Studio:

- Interfaccia Utente Grafica: LM Studio offre un’interfaccia simile a quella di ChatGPT, che rende più semplice l’interazione con vari LLM.

- Installazione di Modelli: Gli utenti possono facilmente trovare e installare LLM localmente, utilizzando l’interfaccia grafica per cercare e scaricare i modelli.

- Privacy: Poiché i modelli vengono eseguiti localmente, gli utenti hanno un controllo maggiore sui propri dati, senza dipendere dalle grandi aziende tecnologiche.

- Requisiti Hardware: Per un’esperienza ottimale, si raccomanda un sistema con almeno 16GB di RAM e, per i PC, oltre 6GB di VRAM. Sono supportate le GPU NVIDIA e AMD.

- Compatibilità con Modelli: LM Studio supporta qualsiasi modello compatibile con ggml su Hugging Face, come LLaMa, MPT e StarCoder.

Per installare LM Studio su Linux è necessario scaricare l’AppImage dal sito ufficiale di LM Studio. I link per il download sono direttamente nella pagina Home del sito Web. Se è la prima volta che si usa un programma AppImage sappi che non è necessaria nessuna installazione ma segui questi passaggi:

- Rendi eseguibile il file AppImage: Apri il Terminale e naviga nella cartella dove hai scaricato il file AppImage e rendi il file eseguibile con il comando:

chmod:chmod +x nomefile.AppImage

Sostituiscinomefile.AppImagecon il nome esatto del file che hai scaricato. - Esegui l’AppImage: Dopo aver reso il file eseguibile, puoi avviarlo direttamente dal terminale con:

./nomefile.AppImage

Oppure, se preferisci, puoi fare doppio clic sul file AppImage dal file manager per avviarlo. - Opzionale – Integrazione con il sistema: Alcuni file AppImage offrono la possibilità di integrarsi nel sistema, aggiungendo icone al menu delle applicazioni. Se questa opzione è disponibile, ti verrà chiesto durante il primo avvio.

Adesso dovresti essere in grado di utilizzare l’applicazione LM Studio sul tuo sistema Linux. Se incontri problemi, assicurati che il file in formato AppImage sia stato scaricato correttamente e che non ci siano errori di permessi.

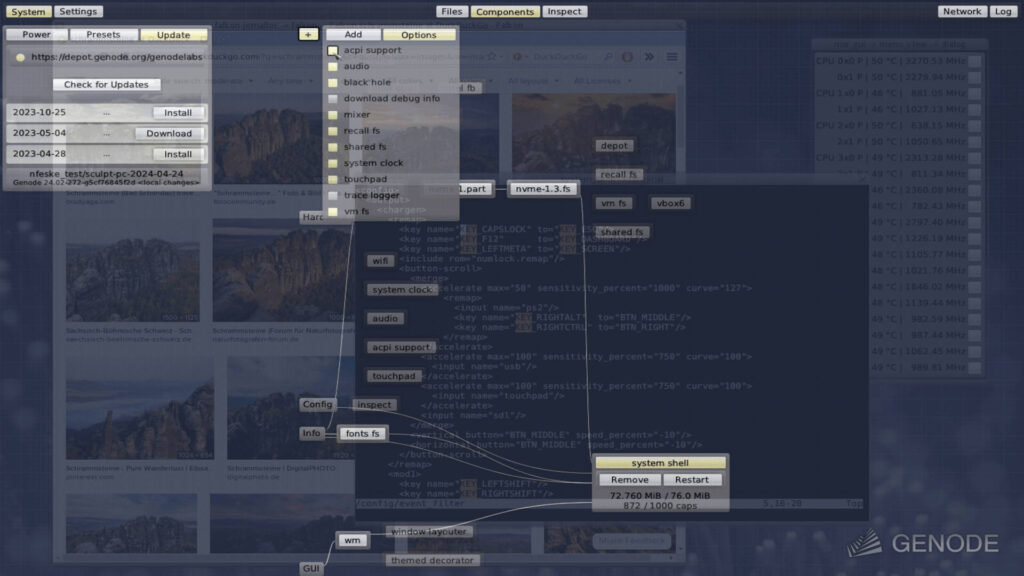

Una volta installato LM Studio, puoi:

- Cercare modelli AI utilizzando la barra di ricerca o incollare direttamente gli URL dei repository da Hugging Face.

- Scaricare il modello desiderato, prestando attenzione alle specifiche e ai requisiti.

- Eseguire il modello scaricato, caricandolo e interagendo con esso attraverso la sezione “Chat” dell’applicazione.

Se si osserva attentamente, si noterà che ci sono 4 opzioni sulla stessa riga del modello AI scelto e tra queste una che cita “FULL GPU OFFLOAD POSSIBLE”. Devi scegliere un modello con questa opzione perché LM Studio ha già analizzato le risorse del tuo sistema e ti suggerisce le scelte più adatte.

Puoi scaricare quanti modelli vuoi ma poi caricarne uno solo alla volta e tutto quello che devi fare è andare nella sezione “Chat” (emoji della bolla della chat a sinistra), in alto cliccare sul menu a tendina con scritto “Select a model to load” e da sotto puoi seleziona qualsiasi modello che hai scaricato.

Ecco alcuni Large Language Models (LLM) che potresti considerare per LM Studio:

- Llama 3: Questo modello di Meta è disponibile in 2 versioni, con 8 miliardi e 70 miliardi di parametri. È adatto a una vasta gamma di applicazioni e supporta dati in oltre 30 lingue.

- Phi-3: Un modello ideale per generare “embeddings” di testo localmente, utile per applicazioni come “retrieval augmented generation” (RAG). Ovvero per creare testi, riassunti, traduzioni ed altre elaborazioni di testo.

Per iniziare, puoi utilizzare la funzione di ricerca di LM Studio per trovare e scaricare il modello che preferisci, la scelta è ampia.

In un sistema con hardware normale, diciamo del costo inferiore ai 1000 Euro la velocità di risposta sarà lenta (dipende anche dalla domanda posta e da quale LLM è in uso) ed è da considerarsi normale aspettare diversi secondi prima che inizi a rispondere e 1 o più minuti prima che venga completata la risposta ma se avete un hardware adeguato con molti GB di RAM e altrettanti di VRAM allora le prestazioni possono diminuire assai e, ad esempio, per compiti di aiuto alla programmazione LM Studio con il giusta LLM può diventare un valido aiuto.

In futuro tutto questo sarà normale con l’arrivo di CPU con integrato il supporto hardware all’AI e al continuo aumento delle capacità di memoria dei sistemi offerti commercialmente ma purtroppo ad oggi non tutti potranno usare LM Studio proficuamente.

LM Studio viene distribuito con una licenza che permette l’uso gratuito per scopi personali. LM Studio non è distribuito come software open source. La licenza sotto cui viene rilasciato per scopi personali non include l’accesso al codice sorgente o la libertà di modificarlo e ridistribuirlo. Inoltre, per l’utilizzo in contesti aziendali o commerciali, sono previste condizioni specifiche che richiedono un accordo con i creatori di LM Studio. Per ulteriori informazioni sulla licenza e le restrizioni d’uso, è sempre consigliabile consultare la documentazione ufficiale fornita con il software.

Attualmente LM Studio è in fase beta per Linux, il che significa che potrebbero esserci aggiornamenti e miglioramenti continui. Per ulteriori dettagli tecnici e documentazione, si può fare riferimento alla documentazione ufficiale di LM Studio.

Se vuoi sostenerci, puoi farlo acquistando qualsiasi cosa dai diversi link di affiliazione che abbiamo nel nostro sito o partendo da qui oppure alcune di queste distribuzioni GNU/Linux che sono disponibili sul nostro negozio online, quelle mancanti possono essere comunque richieste, e su cui trovi anche PC, NAS e il ns ServerOne. Se ti senti generoso, puoi anche donarmi solo 1€ o più se vuoi con PayPal e aiutarmi a continuare a pubblicare più contenuti come questo. Grazie!

Hai dubbi o problemi? Ti aiutiamo noi!

Se vuoi rimanere sempre aggiornato, iscriviti al nostro canale Telegram.Se vuoi ricevere supporto per qualsiasi dubbio o problema, iscriviti alla nostra community Facebook o gruppo Telegram.

Cosa ne pensi? Fateci sapere i vostri pensieri nei commenti qui sotto.

Ti piace quello che leggi? Per favore condividilo con gli altri.

![[GUIDA] Come spegnere automaticamente Ubuntu ad un orario predefinito 2 [GUIDA] Come spegnere automaticamente Ubuntu ad un orario predefinito](https://www.lffl.org/wp-content/uploads/2021/07/shutdowntimer.png)

Una risposta

[…] abbiamo visto LM Studio e oggi conosciamo un approccio diverso per rendere semplice la ricerca e l’uso della […]